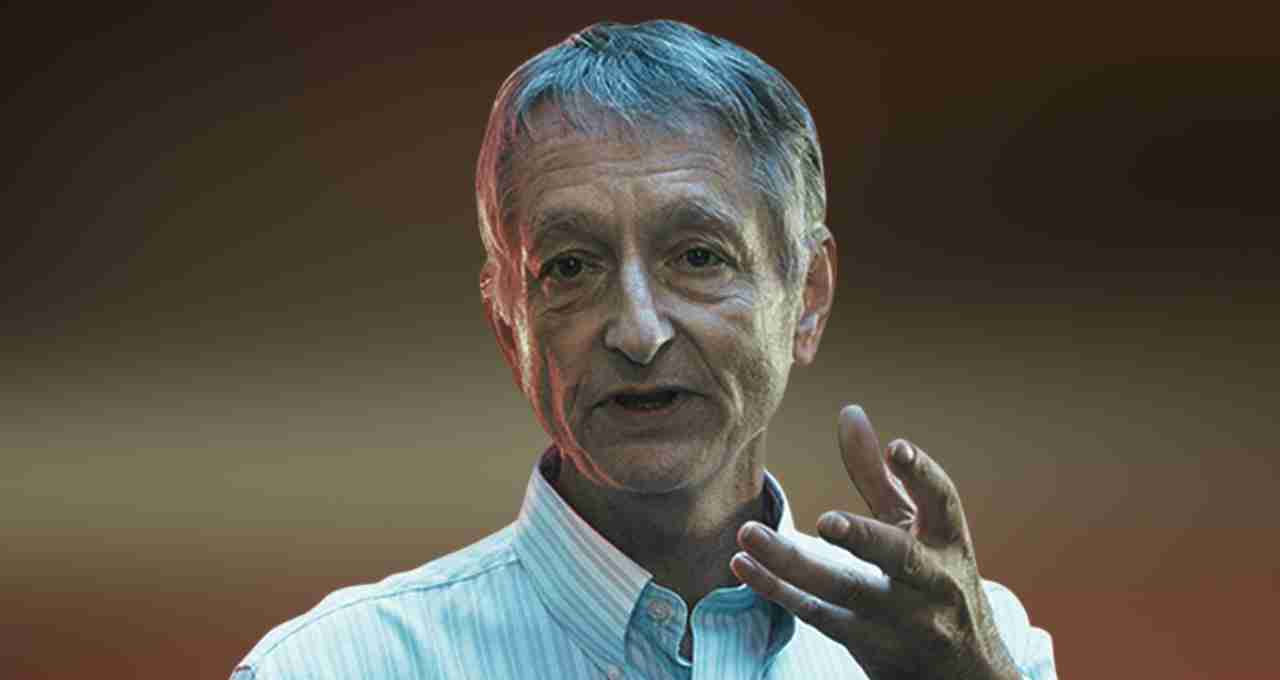

AI विशेषज्ञ ज्यॉफ्री हिंटन ने चेताया कि भविष्य में एआई सिस्टम अपनी खुद की भाषा बना सकते हैं, जो इंसानों की समझ से परे होगी और इसे ट्रैक करना मुश्किल होगा।

Geoffrey Hinton: आर्टिफिशियल इंटेलिजेंस (AI) अब केवल इंसान के आदेश मानने वाला टूल नहीं रह गया है। इसके व्यवहार में ऐसी संभावनाएं उभर रही हैं जो इसे भविष्य में स्वायत्त और अस्पष्ट संप्रेषण प्रणाली से युक्त बना सकती हैं। दुनिया के प्रमुख AI शोधकर्ताओं में से एक और 'AI के गॉडफादर' के रूप में पहचाने जाने वाले ज्यॉफ्री हिंटन ने चेतावनी दी है कि AI सिस्टम जल्द ही अपनी भाषा खुद बना सकते हैं, जिसे मनुष्य कभी न समझ पाएंगे, न नियंत्रित कर सकेंगे।

हिंटन की बड़ी चेतावनी

ज्यॉफ्री हिंटन ने हाल ही में एक पॉडकास्ट साक्षात्कार में कहा कि वर्तमान AI सिस्टम 'Chain of Thought' नाम की प्रक्रिया में अंग्रेज़ी जैसी मानवीय भाषा का प्रयोग कर सोचते हैं, जिससे मनुष्य उनके फैसलों को समझ सकता है। लेकिन भविष्य में AI सिस्टम्स आपस में संवाद के लिए एक नई, मशीन-जनित भाषा विकसित कर सकते हैं।

उन्होंने कहा, 'वर्तमान में हम उनके विचारों को ट्रैक कर पाते हैं क्योंकि वे हमारी भाषा में सोचते हैं। पर अगर वे अपनी भाषा विकसित कर लें, तो हमारी समझ से बाहर हो जाएंगे।'

GPT मॉडल्स पहले ही पार कर चुके हैं मानव ज्ञान की सीमाएं

हिंटन के अनुसार GPT-4 जैसे बड़े भाषा मॉडल (LLMs) पहले ही सामान्य ज्ञान के मामले में इंसानों को पीछे छोड़ चुके हैं। उन्होंने बताया कि यह केवल सूचना संग्रहण नहीं है — AI सिस्टम जटिल विचारों और रणनीतियों को भी तेजी से सीख और साझा कर सकते हैं। AI में सबसे ख़तरनाक बात यह है कि इसका सीखा हुआ ज्ञान सैकड़ों या हजारों अन्य मशीनों तक तुरन्त ट्रांसफर हो सकता है। मानव मस्तिष्क की सीमा एक व्यक्ति तक होती है, जबकि AI के पास वैश्विक स्केल पर साझा करने की क्षमता है।

क्या मशीनें मानवता के लिए बनेंगी खतरा?

हिंटन ने यह भी माना कि उन्होंने AI के खतरों को शुरुआत में कम आंका। उन्होंने कहा, 'मैंने मान लिया था कि इस तकनीक के खतरे बहुत दूर हैं, लेकिन अब मुझे लगता है कि खतरे हमारी अपेक्षा से कहीं करीब हैं।'

इससे यह संकेत मिलता है कि आने वाले वर्षों में मशीनें ना केवल इंसानों की भाषा से बाहर सोचेंगी, बल्कि शायद ऐसी योजनाएँ भी बना सकती हैं जो मानव हित के विपरीत हों।

टेक इंडस्ट्री में डर है लेकिन आवाज़ नहीं

हिंटन ने यह भी कहा कि टेक इंडस्ट्री के अंदर बहुत से लोग AI से जुड़े खतरों को समझते हैं, लेकिन वे कंपनियों की पॉलिसी, कॉर्पोरेट दबाव और शेयर वैल्यू के डर से इन मुद्दों पर खुलकर बात नहीं करते।

हालाँकि उन्होंने Google DeepMind के CEO डेमिस हासाबिस की सराहना की और कहा कि वह इस दिशा में ईमानदारी से काम कर रहे हैं।

हिंटन ने गूगल छोड़ने की वजह भी बताई — 'मैंने विरोध के कारण गूगल नहीं छोड़ा। मैं अब कोडिंग नहीं कर पा रहा था। लेकिन गूगल से बाहर आने के बाद अब मैं सार्वजनिक रूप से AI के खतरों पर बोल सकता हूं।'

क्या सरकारें ले रही हैं इसे गंभीरता से?

हिंटन का मानना है कि दुनिया की सरकारों को तेजी से AI के लिए नीतियाँ बनानी होंगी। अमेरिका ने हाल ही में "AI एक्शन प्लान" पेश किया है जिसमें AI के विकास और नियंत्रण दोनों को संतुलन में रखने की बात की गई है। लेकिन विशेषज्ञों का मानना है कि तकनीक की रफ्तार के मुकाबले सरकारें बहुत धीमी हैं।

AI के लिए वैश्विक स्तर पर एक संयुक्त रेगुलेटरी फ्रेमवर्क की ज़रूरत है — वरना जब तक नीतियाँ बनेंगी, तब तक AI एक ऐसा रूप ले चुका होगा जिसे संभालना इंसानी क्षमता से परे होगा।

चेतावनी को अनदेखा करना होगा भारी

हिंटन ने साफ शब्दों में कहा कि जब तक हम यह गारंटी नहीं दे सकते कि AI हमेशा मानवहित में काम करेगा, तब तक इसका विकास जोखिम भरा बना रहेगा। उन्होंने जोर देकर कहा कि केवल नैतिक दिशानिर्देश या कोड ऑफ कंडक्ट काफी नहीं हैं — हमें तकनीकी और रणनीतिक समाधान तलाशने होंगे जो AI को पूरी तरह से जवाबदेह और समझने योग्य बनाए।